Abstract

在现实世界中自监督预测的好奇心驱动的探索,能够提供给agent的奖励非常少,或者根本不存在。在这种情况下,好奇心可以作为一种内在的奖励信号,使agent能够探索环境并学习可能在以后的生活中有用的技能。本文把好奇心表述为一个agent在视觉特征空间预测自身行为结果的能力时的误差,并把这种error作为内在好奇心reward提供给agent进行学习,该视觉特征空间是由一个自监督逆动态模型学习的。

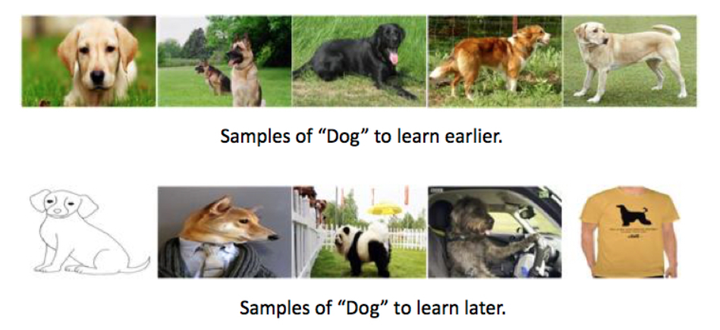

我们的公式扩展到像图像这样的高维连续状态空间,绕过了直接预测像素的困难,并且,关键的是,忽略了不能影响代理的环境方面。所提出的方法在两个环境中进行评估(VizDoom和Super Mario Bros)。研究了三个广泛的环境:1)稀疏的外部奖励,在这种奖励中好奇心使得与环境的互动更少以达到目标;2)没有外在回报的探索,好奇心驱使代理人更有效地探索;和3)推广到看不见的sce-narios(例如,同一游戏的新级别),在这里,从早期经验中获得的知识帮助代理人比从头开始更快地探索新的地方。

Fig2 看图是两个loss,一个是Forword model 用$at$和$φ(s_t)$ 去预测$\hat{φ}(s{t+1})$, 一个是Inverse model 用$st$和$s{t+1}$预测所采取的动作$a_t$。

Self-supervised prediction for exploration

自监督的探索目标不是手动设计每个环境的特征表示,而是提出一种学习特征表示的通用模型,使得学习特征空间中的预测误差提供良好的内在奖励信号。我们提出这样一个特征空间可以通过训练具有两个子模块的深层神经网络来学习:第一子模块将原始状态编码为特征向量φ(st),第二子模块将编码两个后续状态的$φ(st)$、$φ(s{t+1})$的特征作为输入,并预测代理从状态$st$到$s{t+1}$移动所采取的动作($a_t$)。训练这个神经网络相当于学习功能,定义为:

其中$\hat{a_t}$是对动作$a_t$的预测估计值,并且训练了神经网络参数θ来进行优化。

其中,$L_I$是损失函数,用于衡量预测的action与实际action之间的差异。在$a_t$离散情况下,输出g是在所有可能的动作上均具有最大柔和的分布,并且在多项式分布下将θ的最大似然估计的数量最小化。学习的功能也称为逆动力学模型,元组(st,at,st + 1)要求在代理使用其当前策略与环境交互时获得的学习信息。

除了逆动力学模型(inverse dynamics model)外,还训练了另一个神经网络,该神经网络以$a_t$和$φ(s_t)$作为输入,并预测时间$t + 1$处状态的特征编码。

其中,$\hat{φ}(s{t+1})$是通过最小化损失函数$L_F$而预测的$φ(s{t+1})$ ,应用神经网络参数$θ$预测估计值:

学习的函数$f$也称为正向动力学模型, 内在奖励信号$r^i_t$计算为:

其中$η> 0$是比例因子。 为了生成基于好奇心的内在奖励信号,我们共同优化了方程3和5中分别描述的正向f和逆向g动力学损失。 逆模型学习一个特征空间,该特征空间对只与预测代理的行为有关的信息进行编码,而正向模型则在该特征空间中进行预测。

The inverse model learns a fea-ture space that encodes information relevant for predictingthe agent’s actions only and the forward model makes pre-dictions in this feature space.

本文将提出的好奇心函数称为 Intrinsic Curiosity Module(ICM)。由于没有动力诱使该特征空间对那些不受代理行为影响的任何环境特征进行编码,因此该代理将不会因无法预测的环境状态而获得任何奖励,它的探测策略将对干扰物的存在、光照的变化或环境中其他讨厌的变化来源具有很强的适应性。 参见图2的说明,Agrawal 在2016年构造了一个joint inverse-forward model 来学习推物体的特征表示。 但是,他们只是将forword model用作训练inverse model 特征的正则化函数,而本文将forword model预测中的error用作训练agent policy的好奇心奖励。agent所解决的总体优化问题是由公式1、3和5组成,可以写成:

其中0≤β≤1是权重,其权重是逆模型损失与正向模型损失之间的关系,而λ> 0 标量是权衡策略梯度损失的重要性与学习内在奖励信号的重要性之间的关系。

Experiment

本文定性和定量地评估了在有和没有内在好奇心信号的情况下,在两种环境下(VizDoom和Super Mario Bros)学习策略的性能。

评估了三个广泛的设置:a)达成目标时稀疏的外在奖励; b) 无外部奖励的探索; c)本文提出的新的场景。

Future work

未来研究的一个有趣方向是将学习到的探索行为/技能用作更复杂的分层系统中的原始/低级策略。 例如,本文的VizDoomagent学会沿着走廊行走,而不是撞到墙壁上。 这对于导航系统可能是一个有用的原语。尽管丰富多样的现实世界为交互提供了充足的机会,但奖励信号却很少。 本文的方法在这种情况下表现出色,并将影响代理的意外互动转化为内在奖励。 但是,本文的方法并未直接扩展到“互动机会”都很少见的情况。 在理论中,可以将此类事件保存在 replay memory中,并使用它们来指导探索。 但是,本文将此扩展留给以后的工作。